La aparición de altavoces inteligentes ha potenciado el uso de los asistentes de voz. La primera interacción entre consumidor y máquina, cuya conversación coloquial invita a dotar de Inteligencia Emocional a Alexa, Siri o Google Assistant. Pero la computación afectiva no resulta únicamente de interés para las grandes tecnológicas. Los call centers, los diseñadores de chatbots o los fabricantes de automoción son algunos de los atrevidos en experimentar con esta tecnología.

No siempre las experiencias de cliente implantadas arrojan resultados satisfactorios para los usuarios. Muestra de ello, los asistentes de voz, aspirantes a convertirse en la mano amiga a la que acudir cuando se desea consultar el tiempo, buscar reseñas de un producto o realizar un pedido. Una tarea que, a ojos humanos, puede resultar sencilla, pero no así para las máquinas, que deben aprender a perfilar con destreza la consulta y entregar, a cambio, la respuesta adecuada. A esta complejidad se le suma otra: la necesidad de detectar el estado emocional del usuario.

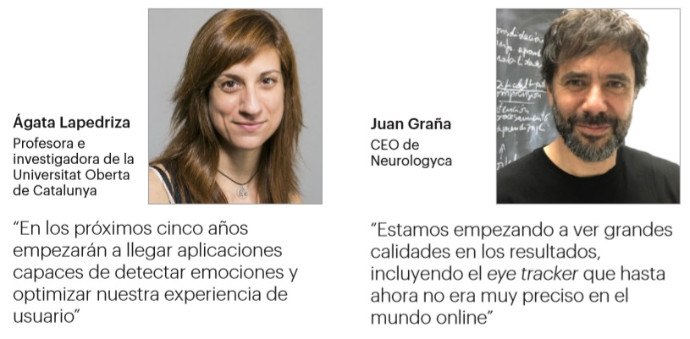

Precisamente, el desarrollo de interfaces como Siri, Alexa o Google Assistant está incentivando el interés por la computación afectiva, la rama de la Inteligencia Artificial que persigue entender las emociones de las personas e inculcar dicho conocimiento en las máquinas. ¿El motivo? Según Ágata Lapedriza, profesora e investigadora de la Universitat Oberta de Catalunya, mejorar la capacidad de asistencia de éstas. “Si necesitas una máquina que te ayude a hacer algo y ésta detecta que estás frustrado, se dará cuenta de que hay algo que no funciona y es posible que deba hacer un cambio”, señala la investigadora a IPMARK, quien cita, además, el gran abanico de aplicaciones que tiene este campo, como la capacidad de detectar de manera precoz la aparición de enfermedades, la depresión por ejemplo, o animar a los usuarios a cambiar hábitos nocivos por otros más saludables.

En el caso de los asistentes de voz, la aparición de este tipo de aplicaciones ha originado el inicio del diálogo entre usuarios y máquinas. Y en este diálogo, que de acuerdo con Lapedriza, es “llano y muy coloquial”, las emociones ejercen un papel importante, ya que se espera que la máquina entregue una respuesta empática y emocionalmente inteligente. Es decir, que “adapte el tipo de respuesta al estado emocional percibido, que es lo que hacemos los humanos. Cuando alguien te habla y está triste, tú adaptas tu tono y tu vocabulario para dar una respuesta empática a esta persona”, explica.

Según datos de MarketsandMarkets, se calcula que el mercado global de la computación afectiva pase de los 22.200 millones de dólares en 2019 hasta los 90.000 millones en 2024. Un crecimiento del 32,3%, auspiciado por la demanda de programas informáticos en el sector educativo para ganar eficiencia en el terreno online; el uso creciente de herramientas de ayuda en el ámbito médico, y la incipiente necesidad de captar la personalidad y el comportamiento de los consumidores.

El online, la próxima gran conquista del neuromarketing

Sobre este último aspecto, varios avances se han dado en el campo del neuromarketing. Según cuenta a esta publicación Juan Graña, CEO de Neurologyca, a día de hoy existen más conocimientos y tecnologías que permiten llegar más lejos en la comprensión y el conocimiento de las emociones. Un objetivo que se puede alcanzar de dos formas. “Forzando un estudio de campo para someter a las personas a los estímulos u observando con tecnologías cómo esas personas se comportan o reaccionan emocionalmente cuando están en un entorno determinado”.

Entre tales tecnologías, Graña cita el eye tracker, el electroencefalograma, el ritmo cardiaco, la apertura y el cierre de pupila o la codificación facial, que pueden emplearse en el terreno físico, pero también en el digital. Y es ahí donde se hallan los mayores avances, de acuerdo con el experto. “Estamos empezando a ver grandes calidades en los resultados, incluyendo el eye tracker que hasta ahora no era muy preciso en el mundo online. Ya tenemos datos y la algoritmia creada para obtener sistemas de calibración que nos permitan dar un resultado final mucho más preciso”.

Eclosión en cinco años

Pero haber alcanzado estos avances no implica que se hayan solventado las principales barreras que impiden el desarrollo de programas de Inteligencia Artificial capaces de detectar las emociones de las personas. Lapedriza cita, por un lado, el propio desconocimiento que existe en torno a las emociones humanas. “No entendemos muy bien por qué comunicamos las emociones y cómo las comunicamos, y por qué las percibimos y cómo las percibimos, con lo cual, al final, estás intentando simular algo que realmente no entiendes”, señala la investigadora, que pone como ejemplo el hecho de que no se haya alcanzado aún un acuerdo en torno a las categorías de emociones que existen o que haya palabras como felicidad que no están presentes en todos los idiomas.

Se suma otra dificultad técnica: la falta de modelos computacionales que tengan en cuenta la subjetividad. Por ejemplo, el uso de programas de reconocimiento de imagen que identifican con éxito los objetos que hay en una fotografía, pero fallan a la hora de identificar las emociones de las personas que se encuentra en ésta.

Aun así, la investigadora considera que, en los próximos cinco años, la altura de estas barreras disminuya y se empiece a divisar aplicaciones capaces de detectar nuestras emociones y optimizar, por ende, nuestra experiencia como usuarios, y ello, ante la multitud de pruebas que se están realizando actualmente. Lapedriza cita las pruebas realizadas en call centers para detectar el nivel de enfado de los clientes, o las llevadas a cabo en Automoción para el desarrollo de sistemas inteligentes de conducción asistida.

Diversas fuentes de información

A la hora de detectar las emociones de los usuarios son varias las fuentes a las que poder consultar. La expresión de la cara, el ritmo cardíaco, el movimiento de la persona mientras habla, su respiración, la presión sanguínea, la conductividad de la piel o el tono de voz son algunas de ellas. Sin embargo, si se desea obtener una imagen completa de las emociones de una persona, resulta necesario aplicar la multimodalidad. De acuerdo con Ágata Lapedriza (UOC), este concepto hace referencia al hecho de observar varias fuentes de información y crear varios algoritmos que permitan procesar los datos “para intentar reconocer con el máximo detalle qué es lo que le está pasando a esta persona, y entendiendo que cada una de las señales procesadas proporciona una información diferente, pero que, combinadas, permite hacer un reconocimiento más detallado”.

El contexto complica aún más la tarea, sobre todo, si el contacto con la persona se realiza en el plano digital. Según explica Juan Graña, de Neurologyca, a nivel físico, la fuente más fidedigna de información es el encefalograma, que combinado con las pulsaciones cardíacas, las expresiones faciales o la respuesta orgánica de la piel, otorga un dato más rico y riguroso. Sin embargo, “en el mundo online no puedes ir casa por casa, poniéndoles a las personas todas estas máquinas”.

Aquí se deben emplear tecnologías no intrusivas, como el eye tracker o el reconocimiento facial – cuyas expresiones se detectan a través de la cámara del dispositivo móvil o la webcam del PC-, indica Graña. Que el dato obtenido resulte fiel dependerá del propio algoritmo -“tiene que ser muy bueno para poder hacer esto”-, y de la muestra de usuarios a los que se le aplica el estudio. “Si en un estudio normal, con una muestra de 50 personas, obtienes un dato veraz, en el mundo online tendrás que subirlo a 1.000 personas”, señala.

TEXTO PILAR CHACÓN