«El sistema solar está repleto de datos. Cada roca, cada polvo interestelar, cada pulso de energía, cada rayo cósmico es una información que se puede recopilar, analizar y utilizar».

Arthur C. Clarke, «2001: Una odisea espacial«.

Les propongo un reto: piensen en un sector de actividad en cuyas tendencias no exista una que implique la utilización de los datos masivos para distintos fines. ¿Se les ocurre? Resulta completamente imposible.

Los datos se han vuelto parte intrínseca de todas las industrias y los usos que se dan a los mismos se han multiplicado: ya no sólo utilizamos datos para la toma de decisiones estratégicas, los usamos para la mejora de procesos, para la creación de nuevo contenido, para la automatización de tareas, para la simulación de un entorno real en un gemelo digital, para la conducción de un vehículo. También son datos la evolución de crecimiento de una determinada plantación, así como sus patrones de riego, temperatura y horas de sol. Hasta sectores tradicionalmente fuera de la digitalización como la construcción se están viendo impactados por el uso de los datos y las implicaciones que conllevan.

Los datos han dejado de tener un origen específico para incorporar una perspectiva holística: son datos las respuestas a un cuestionario, la información de temperatura de una determinada máquina, el patrón de movilidad de unos determinados ciudadanos, la información que publicamos en redes sociales, el precio de los productos que consultamos, las fotografías, los videos, el audio, las interacciones de los usuarios con contenidos digitales, los clics, las búsquedas… todo es potencialmente reducido a datos.

El reto de cuantificar el sector de la investigación

Pero si los datos son el lenguaje universal del universo, ¿cuáles son los límites del mercado de la investigación? ¿Cuál es nuestro sector de actividad? Para responder a esta pregunta desde Insights + Analytics y desde ESOMAR se han llevado a cabo distintos estudios en los que se intentan delimitar -y cuantificar- el tamaño del mercado de la investigación.

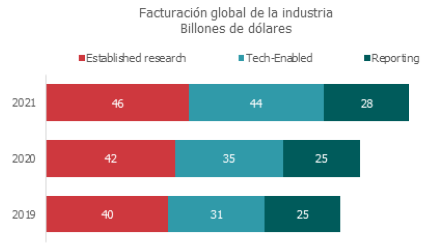

Según el último estudio de ESOMAR para 2021 la industria de la investigación a nivel global alcanzaba un tamaño de mercado 118 billones de dólares[1]. Estando repartida en tres grandes subsectores: established research, tech-enabled y reporting. Otras investigaciones cuantifican el mercado del Big Data en 215 billones de dólares[2]. Ambos estudios miden sectores y empresas diferentes por lo que en realidad podríamos estar hablando de un mercado global -el basado en los datos- de un valor de 333 billones de dólares en 2021 y con importantes crecimientos para los próximos años.

[1] Global Market Research, 2022 – Esomar

[2] Worldwide Big Data and Analytics Spending Guide, 2022– IDC

En España las cifras de tamaño de mercado que permiten llevar a cabo una comparativa todavía no existen, actualmente la forma de medir el mercado corresponde al perímetro de empresas cuyo foco principal sigue siendo la investigación, pero deja fuera el número de empresas que, aunque proporcionando otros servicios, prestan también servicios que pueden considerarse investigación o que al menos están basados en datos.

Teniendo en cuenta este perímetro de mercado el tamaño en España alcanzaría 521 millones de euros de facturación en 2021. Lo que supone recuperar el volumen de facturación de 2019. A pesar de que estas cifras suponen una aproximación para determinar el tamaño de mercado de la investigación, lo cierto es que la medición completa del sector es un trabajo muy complejo: cada vez más empresas lanzan servicios específicos, poniendo en valor los propios datos que recopilan e intentando crear nuevas vías de ingresos para la compañía. Otras estimaciones son proporcionadas por ASEDIE basadas en la facturación correspondiente a los códigos CNAE estima un mercado de más de 2.000 millones de euros en el año 2020. Ambas estimaciones tienen sus limitaciones y siguen dejando fuera una parte importante del mercado de los Insights y Analytics.

Para desarrollar una medición acorde al tamaño -y la capilaridad del mercado de la investigación y data- sería necesaria una colaboración entre distintas entidades que permitiera tener una información mucho más precisa del tamaño de un mercado que no deja de crecer y de impactar a nuevos sectores de actividad. Es uno de los retos que tenemos como asociación y que debemos afrontar a lo largo de 2023.

Principales tendencias en el sector

Analizar las principales tendencias en el sector de la investigación vuelve a suponer un reto mayúsculo. De hecho, en 2015 Gartner dejó de llevar a cabo su tradicional análisis de adopción de Big Data porque consideraba que esta tecnología estaba tan presente en distintas industrias, y fragmentado en distintas tecnologías, que no tenía sentido considerarlo de manera aislada. Algo similar ha sucedido con el mercado de la investigación. Su adopción por parte de múltiples sectores como una línea de trabajo adicional ha provocado que la cantidad de tendencias se incrementen exponencialmente: hay algunas tendencias que aplican al mundo del marketing, otras al ámbito del IoT, al estudio de la movilidad, al seguimiento de competidores o a la estrategia de las compañías. Sería imposible llevar a cabo un listado completamente exhaustivo. Debido a esto, en el siguiente listado, no están todas las que son, pero son todas las que están.

- De un único research buyer persona a múltiples actores secundarios:

Uno de los cambios que se han vivido en el lado del cliente en los últimos años es cada vez se ha desdibujado más el rol del investigador de mercado dentro de las organizaciones. Cada organización ha dotado el rol del investigador de una variedad de funciones, pero muchas otras han quedado dispersas dentro de otros departamentos. Si en el pasado nos encontrábamos con departamentos de investigación que concentraban la mayor parte de los estudios que se llevaban a cabo en la empresa. En la actualidad, muchos de estos estudios pertenecen a otro tipo de departamentos internos. La investigación, y la realización de estudios, no es un monopolio del responsable de investigación de una organización: los estudios de satisfacción, los programas enfocados a la innovación de producto, las entrevistas con clientes, los programas de excelencia comercial acaban estando dirigidos por distintos departamentos, y son realizados en muchos casos por profesionales que provienen de otros ámbitos, que en algunos casos carecen de una formación técnica adecuada para la supervisión y realización de estos proyectos. Esta dispersión ha provocado una pérdida de la importancia de la investigación per sé dentro de las organizaciones: cualquier profesional, sea cual sea su expertise, puede coordinar un conjoint, un estudio de satisfacción, una cuantificación de mercado, un estudio de eficacia publicitaria. Pero lo cierto es que, a la hora de entender las limitaciones, las posibilidades, y los procedimientos para garantizar la calidad de la investigación, las carencias afloran y el impacto que estas investigaciones puede tener acaba siendo limitado. Es éste un mal endémico de la investigación, en un mundo en el que la información, los datos y la investigación suponen poder, todos los departamentos -todos los profesionales- van a querer su cuota.

- Do It Yourself:

En línea con la tendencia anterior, y con la dispersión que implícita de los presupuestos de investigación, se ha establecido dentro de las organizaciones la práctica de hacer uno mismo la investigación. Esta tendencia esta apoyada sin duda en otros factores: la reducción o limitación de presupuestos, la disponibilidad de información gracias a Internet y la capacidad tecnológica que permite el lanzamiento de investigaciones de forma interna.

Todos estos factores han provocado que según los últimos datos de Esomar el 48% de los proyectos de investigación realizados en 2020 fueran desarrollados de forma interna[1]. Esto supuso un incremento de ocho puntos porcentuales desde el 2019 y es una tendencia que sigue creciendo dentro de los clientes.

Internet es un mar de contenido para cualquier investigación: informes de institutos, estadísticas públicas, informes de consultoras, análisis de verticales, plataformas de integración de datos están disponibles para ser consultados. Todas estas plataformas han facilitado la posibilidad de llevar a cabo un primer desk research con fuentes públicas que permiten en muchos casos disponer de información suficiente -quizás no para una decisión estratégica que implique grandes inversiones- pero si para una primera orientación o para la mayor parte de los estudios tácticos.

[1] Users & buyers global Insights study 2021 ESOMAR

- Inteligencia artificial generativa:

No podíamos hablar de tendencias en investigación y dejar de lado la implantación de la inteligencia artificial generativa. En muy corto espacio de tiempo, y a pesar de las limitaciones, la aparición de estas soluciones se implementará como una herramienta adicional para el investigador. ChatGPT y otras de las aplicaciones que se han creado basadas en la IA generativa son una pestaña adicional a Excel, PowerPoint o al buscador. Es una forma de automatizar la búsqueda de información y de encontrar nuevos caminos para seguir investigando.

En la actualidad existen ya multitud de usos en los que se pueden utilizar:

- Elaboración de un primer boceto de cuestionario.

- Recopilación de estadísticas públicas.

- Recopilación de información y muestra ordenada.

- Asistente de ayuda para trabajos complejos en Excel.

- Elaboración del diseño de presentaciones.

- Generar ilustraciones asociadas al contenido.

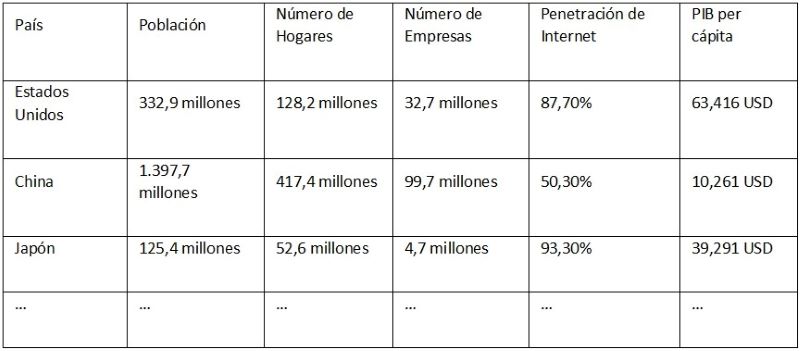

La lista de posibles usos seguirá en aumento en los próximos años y los profesionales que no adopten estas nuevas tecnologías como una herramienta más de trabajo serán mucho menos eficientes en el día a día. Por poner un ejemplo rápido: ¿Cuánto tiempo tardas en recopilar el tamaño de población, número de hogares, número de empresas, PIB por país, de un listado de los 20 países con mayor PIB mundial? Tardas menos de un minuto:

“Dame una tabla en la que tengamos los 20 países más grandes por PIB. En columnas muestra el número de población, número de hogares, número de empresas, penetración de internet y el PIB per cápita. Crea una tabla idéntica abajo en la que muestras la fuente de cada dato.”

“¡Claro! Aquí te presento la tabla con los 20 países más grandes por PIB y otra tabla con la fuente de cada dato:”

Ejemplo:

A pesar de que las fuentes todavía son limitadas, que hay una limitación temporal hasta 2021 y que estamos explorando los primeros usos, las aplicaciones y beneficios de esta nueva tecnología irán en aumento en los próximos años mejorando la eficiencia de muchas de las tareas de un investigador.

- Alternative Data:

Si tradicionalmente para responder a una pregunta de investigación había que producir la información en el momento, en la actualidad existen multitud de fuentes de información que pueden ser utilizadas para responder preguntas de investigación. Algunos de ellos están ampliamente implementados en el sector y en las empresas clientes, pero otros muchos todavía tienen un uso muy limitado. Por poner algunos ejemplos de estos potenciales datos:

- Navegación web: para entender cómo se comportan los usuarios, sus intereses, sus journeys de compra.

- Descargas de Apps: para permitir la estimación del crecimiento de clientes de una determinada compañía.

- Sensores: para medir y automatizar decisiones en logística, fabricación o en el propio hogar conectado.

- Transacciones financieras: para entender el gasto del consumidor sustituyendo los estudios de presupuestos familiares.

- Imágenes de satélite: para conocer la evolución de las ciudades, la asistencia a determinados eventos o lugares.

- Comentarios y valoraciones online: para entender los problemas o beneficios de un determinado producto y actuar en consecuencia.

- Imágenes en redes sociales: para entender los contextos en los que se usa un determinado producto o servicio, analizar tendencias para el mundo de la moda.

- Dispositivos de limpieza del hogar: para analizar la dimensión y distribución de las viviendas así como las características de la misma (Por ejemplo, si tienen mascota).

- Geolocalización: para analizar la forma en la que nos movemos como sociedad y la utilización de los distintos tipos de medios de transporte. Una tipología de datos que irá en aumento con la mayor conectividad actual de los nuevos vehículos.

- Web scrapping: para poder extraer información de cualquier página web y utilizarla con múltiples fines en función del origen.

Según algunas estimaciones en 2022 el tamaño de mercado de los datos alternativos ascendió a 4 billones de dólares, pero se espera que para 2030 el mercado haya alcanzado una cifra de 149 billones de dólares con un CAGR del 55%.[1] Este mercado es sin duda uno de los que más rápido va a crecer en los próximos años y, su utilización, constituirá un factor diferencial en muchas empresas.

Los potenciales usos de estos datos son múltiples: algunos nos permiten responder preguntas clásicas de investigación a partir de otras fuentes distintas -por ejemplo, estimar el crecimiento de una compañía a partir de las descargas o las visitas a un centro comercial o un hospital a partir de imágenes satelitales. Otros, por el contrario, nos permiten automatizar procesos dentro de la compañía o alimentar a los departamentos de marketing de bases de datos de potenciales leads mucho más actualizadas que las actuales.

- Hiperespecialización: todos los sectores potencialmente tienen datos

Esta explosión de múltiples datos ha provocado que desde muchas empresas se genere un enfoque especializado en un ámbito específico de la investigación. Los first party data no sólo se refieren al mundo del marketing sino a cualquier dato que sea capaz de producir una compañía. Encontramos ejemplos en distintas industrias: en el ámbito de la seguridad se disponen de cantidades ingentes de imágenes grabadas a partir de las cámaras CCTV, en empresas de logística y automoción se dispone de información sobre cómo se comportan los distintos vehículos, en empresas enfocadas en el IoT se recogen datos de sensores o, por ejemplo, en los softwares que recogen la actividad en la hostelería y que tienen el detalle del consumo de determinados productos de gran consumo en un sector que tradicionalmente ha sido muy complicado de estudiar.

Para muchas de estas empresas la producción y utilización de estos datos supone un diferencial específico en los servicios que prestan, en otros casos, estos datos pueden suponer un negocio adicional que explorar. Desde distintos sectores y multinacionales se están desarrollando departamentos de Inteligencia que tratan de comercializar estas fuentes de datos: a veces de primera mano abriendo nuevas líneas de negocio, otras en colaboración o partnerships con distintos actores del mercado. Esta tendencia está provocando que se produzca un incremento del número de proveedores de datos e investigación y seguramente sea una tendencia que siga en aumento a lo largo del tiempo.

- Skills shortage: la carestía de profesionales

Si los problemas de reclutamiento es algo que ya está afectando a distintas industrias. Este aumento de la demanda de datos y el incremento de sus potenciales usos está provocando una carestía de profesionales con diversos conocimientos de datos.

Si bien la falta de profesionales con capacidades técnicas para el procesamiento de grandes cantidades de información hace tiempo que viene sucediendo en el mercado, cada vez es más frecuente la falta de profesionales que sean capaces de extraer el valor de estos: de responder a las preguntas de negocio y de extraer conclusiones y no quedarse en meros hechos descriptivos.

Algunas investigaciones en UK muestran que el 48% de las empresas están reclutando profesionales con determinadas habilidades en data, pero un 46% de las mismas tienen dificultades para encontrar estos profesionales[2]. Con el crecimiento de los distintos subsectores de datos e investigación en distintos tipos de empresas -ya no sólo empresas proveedoras sino cualquier empresa que es capaz de recoger datos sobre su propia actividad- la carestía de profesionales que sean capaces de analizar los datos y llevarlos a la acción -que sean capaces de tomar decisiones con los mismos- continuará en aumento.

Una posible solución podría ser incrementar las capacidades de análisis de datos de los distintos perfiles dentro de la empresa, pero trabajar con datos, y especializarse en este ámbito, es algo que requiere tiempo y práctica, algo que está lejos de la disposición del día a día en la gran mayoría de empresas.

- Integración de sistemas y datos: una asignatura pendiente

A pesar de que hace ya algunos años que se viene hablando de la integración de fuentes de datos dentro de la empresa, así como de la creación de sistemas que permitan la consulta de manera estandarizada de los mismos. Sigue siendo una asignatura pendiente en la mayor parte de las grandes organizaciones.

Sectores en los que los que el crecimiento inorgánico es frecuente encuentran grandes dificultades en la migración de los sistemas de información y en la estandarización de la recogida. Por poner un ejemplo, sectores como la logística todavía cuentan en su haber con documentación en papel, a pesar de existir en la actualidad distintas tecnologías que permitirían el seguimiento de mercancías y su trazabilidad en toda la cadena. Transformar distintas industrias requiere de la colaboración de muchas partes (proveedores y clientes) y no siempre es frecuente esta voluntad de colaborar o el mismo grado de desarrollo tecnológico en todas las empresas que lo haga posible.

Otras compañías, una vez que lo consiguen, crean un esquema de accesos tan riguroso que hacen imposible su utilización en la toma de decisiones de negocio. Los datos deberían ser un bien común para el conjunto de los trabajadores de una empresa, pero los miedos a posibles problemas relacionados con GDPR están provocando una restricción en su acceso y consulta.

- El cualitativo también es digital

No podíamos dejar pasar esta oportunidad sin hablar del cualitativo. Quizás el sector de la investigación que se niega a hablar de datos y que sigue teniendo como foco a las personas. Aunque el sector cualitativo tuvo una digitalización más tardía que el mundo cuantitativo, ha sufrido una auténtica implantación acelerada a raíz de la crisis del Covid-19.

Tras los confinamientos en las distintas sociedades fue realmente complicado para muchos de estos profesionales desarrollar su actividad presencial y rápidamente utilizaron distintas plataformas digitales que les permitían seguir explorando el comportamiento de los consumidores, pero a la distancia.

El sector cualitativo ha transformado su forma de trabajar integrando las plataformas digitales de una manera mucho más intensiva en los últimos años, aunque bien es cierto que las metodologías presenciales seguirán teniendo su cabida y su razón de ser, trabajando de manera integrada el mundo digital y presencial cuando lo requieran los objetivos de investigación.

- La ética y la seguridad en la investigación

Para concluir este resumen de tendencias habría que hablar de la importancia de la ética de los datos. El aumento de estas fuentes de información, el conocimiento más preciso de los consumidores, sus preferencias, sus características y su información personal requieren de una pregunta continua sobre la ética de los análisis que llevamos a cabo, del funcionamiento de determinados algoritmos o de las conclusiones que producimos. Disponer de una gran cantidad de datos y analizarlos conlleva una gran responsabilidad.

Esta responsabilidad tiene también que extenderse a garantizar que estos datos están seguros y para ello las organizaciones deben mejorar en sus sistemas de ciberseguridad: bien a partir de sistemas que permiten impedir las fugas de información bien a través de la formación en ciberseguridad de los trabajadores de estas -a veces el escalón más vulnerable en materia de ciberseguridad-.

Para concluir, para continuar, para debatir:

Este artículo comenzaba con una frase de Arthur C. Clarke en Odisea en el espacio que ChatGPT sugirió. Tras múltiples búsquedas no he conseguido encontrar esta frase en el libro al que hace referencia o en cualquier otro escrito del autor. Pero suena perfectamente plausible. Este es uno de los riesgos de la Inteligencia Artificial Generativa: que con esta generación sea capaz de crear contenidos que, aunque plausibles, sean completamente falsos. Por eso esta vez sí me gustaría utilizar una frase real de Arthur C. Clarke que hace referencia a la necesidad de tener datos, analizarlos y finalmente extraer conocimiento. Extraer conocimiento implica la duda, el debate y la discusión, implica la tesis y la antítesis. Este debería ser el único camino para aplicar la tecnología en nuestro sector:

“It is vital to remember that information– in the sense of raw data– is not knowledge, that knowledge is not wisdom, and that wisdom is not foresight. But information is the first essential step to all of these.”

Arthur C. Clarke

Desde Insights + Analytics España tenemos la vocación de integrar todas estas tendencias, el debate que implican, y a los profesionales y empresas que les dan forma, dentro de la organización. Bien a través de los planes de formación, de la red de networking a través de eventos o de los servicios en materia de ética para la investigación. Es uno de los retos más bonitos: poder ser el punto de encuentro de una industria que se encuentra en ebullición, que está transformando el mundo y a la que invitamos a todos a ser partícipes del cambio.

[1] Precedence research, The global alternative market size

[2] Quantifying the UK Data Skills Gap, 2021 – National Data Strategy